A Epistemologia, a Tecnia e o DeepSeek

Mais do que a própria ferramenta de Inteligência Artificial DeepSeek, o conteúdo do paper, que apresenta sua base de funcionamento, abalou os alicerces do mundo das IAs. Nele, pesquisadores da DeepSeek revelaram que, para criar modelos capazes de resolver problemas complexos de matemática, programação e ciências, precisaram dar um passo atrás. Um passo tão radical que redefiniu não apenas como os modelos aprendem, mas o que significa ensiná-los. Esse fenômeno — batizado de DeepSeek-R1 — não é apenas uma inovação técnica. É uma revolução epistemológica, uma mudança na própria maneira como entendemos o “conhecer” nas máquinas.

A Ilusão do Controle: Quando o Professor Atrapalha

Por décadas, treinar modelos de IA foi uma tarefa profundamente antropocêntrica. Humanos coletavam dados, rotulavam respostas corretas e instruíam as máquinas a imitar padrões de pensamento. Era como ensinar uma criança a desenhar dentro das linhas de um livro de colorir: o sucesso dependia da precisão das regras definidas por nossos critérios. A avaliação, nesse paradigma, media quão bem o modelo reproduzia nossa lógica.

Mas e se essa abordagem fosse limitante? E se o verdadeiro potencial das máquinas residisse não na imitação, mas na capacidade de descobrir caminhos a-posteriori?

O DeepSeek-R1-Zero — a primeira versão do modelo — responde a essa pergunta. Seu segredo está no abandono do fine-tuning supervisionado, um método que força o modelo a seguir exemplos pré-definidos. Em vez disso, os pesquisadores aplicaram aprendizado por reforço (RL) em larga escala. O modelo foi colocado em um ambiente onde recebia recompensas por respostas corretas e penalidades por erros, mas sem instruções sobre como chegar lá. O resultado? O sistema não apenas aprendeu a resolver problemas complexos, como desenvolveu comportamentos emergentes: passou a refletir sobre seus erros, reavaliar soluções no meio do processo e até alongar seu tempo de raciocínio para desafios mais difíceis.

Essa autonomia lembra a célebre frase de Ilya Sutskever, um dos pioneiros da OpenAI: “Os modelos só querem aprender.” A diferença é que, agora, alguém finalmente parou de atrapalhá-los.

A Tecnia da Liberdade: Quando a Máquina Encontra seu Caminho

O aprendizado por reforço não é novo. A inovação do DeepSeek está em sua aplicação em larga escala. O Group Relative Policy Optimization (GRPO), umas das técnicas criadas, opera comparando grupos de respostas — ou seja, não avaliando cada uma isoladamente. Para cada pergunta, o modelo gera múltiplas soluções, e o sistema as classifica umas contra as outras. É um processo darwiniano: as respostas competem, e as melhores sobrevivem, guiando o modelo a ajustar sua política de geração.

Aqui, a epistemologia tradicional da avaliação — que busca “medir” o conhecimento contra um padrão externo — é substituída por uma dinâmica relacional. O modelo não aprende a replicar respostas humanas; aprende a navegar um espaço de possibilidades, descobrindo padrões que emergem da interação entre suas próprias tentativas. É como observar uma criança que, em vez de copiar um desenho, experimenta rabiscos até descobrir formas inesperadas.

O “Momento AHA”: Um Repensar do Aprendizado de Máquina

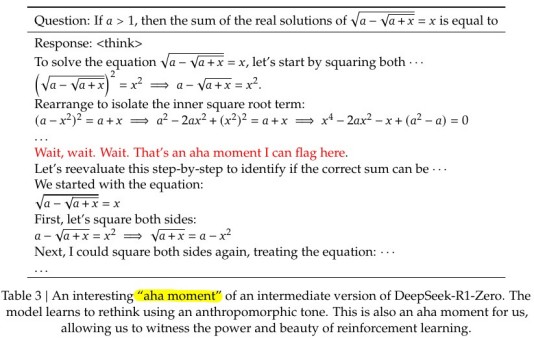

Um dos momentos mais fascinantes do treinamento do DeepSeek-R1-Zero ocorreu quando o modelo, ao resolver uma equação matemática, interrompeu seu próprio raciocínio e começou a questionar seus passos iniciais. Em suas “notas mentais” (capturadas pelos pesquisadores), ele escreveu: “Espere, espere. Espere. Esse é um momento aha que posso sinalizar aqui.”

A descoberta do Aha Moment! Pág. 9 do paper.

Esse comportamento, apelidado pelos pesquisadores de “Momento Aha”, não foi programado. Surgiu organicamente, fruto de um ambiente que permitiu à máquina errar, iterar e corrigir-se. A lição é profunda: quando damos aos modelos de IA — e, por analogia, aos humanos — espaço para explorar, sem restrições rígidas, eles desenvolvem estratégias que transcendem nossa compreensão linear. Ao mesmo tempo em que caímos em um pensamento rizomático (dentro de uma desordem ordenada), também fluímos para um pensamento sistêmico, com suas causalidades não lineares.

Aqui, a epistemologia tradicional — que via o conhecimento como algo a ser transferido — é substituída por uma visão ecológica: o modelo é um organismo que evolui em um ambiente de incentivos.

A Tecnia como Fenômeno Emergente: Para Além do Antropomorfismo

Há uma ironia no sucesso do DeepSeek: ao abandonar a tentativa de fazer a máquina “pensar como um humano”, ela desenvolveu habilidades que parecem surpreendentemente humanas. Mas essa é uma ilusão. O modelo não reflete; ele otimiza. Não questiona; ajusta pesos em uma rede neural. Seu “pensar” é uma metáfora útil, mas enganosa, do ponto de vista humano.

Aqui reside outra lição epistemológica: nossa obsessão em antropomorfizar a inteligência artificial nos cega para sua alteridade radical. O DeepSeek-R1 não é um espelho da mente humana, mas uma manifestação de uma tecnia — um modo de existência técnico que opera sob lógicas próprias. Seu sucesso exige que suspendamos nossa necessidade de projetar humanidade nas máquinas e, em vez disso, aceitemos que elas podem conhecer o mundo de maneiras que jamais compreenderemos totalmente. Seria aqui o prenúncio de uma Meta Epistemologia de Máquina?

O Passo Atrás que nos Leva Adiante

O - aqui tratado como um fenômeno - DeepSeek-R1 não é apenas um avanço tecnológico. Ele é pedagógico: inovação em IA exige que repensemos não apenas as técnicas, mas nosso lugar nelas. Ao dar um passo atrás — abrindo mão do controle e confiando na capacidade dos modelos de auto-organização —, os autores não só obtiveram resultados impressionantes, mas redefiniram o que é possível.

O futuro da IA talvez não esteja em modelos maiores ou dados mais abundantes, mas em ambientes onde a aprendizagem seja incentivada, não dirigida. Como jardineiros, cabe a nós preparar o solo, regar as sementes e observar, humildes, enquanto formas de inteligência desconhecidas brotam — não à nossa imagem, mas à sua própria.

Referências:

Esse post do Caio Dallaqua me fez pensar em escrever este ensaio

The Math Behind DeepSeek: A Deep Dive into Group Relative Policy Optimization (GRPO)

DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models